В эпоху IoT критически важна надёжная аутентификация устройств. Какие принципы лежат в её основе? Как правильно сочетать сертификаты X.509, токены безопасности, многофакторную аутентификацию и другие методы? Какие архитектурные подходы помогут защитить инфраструктуру аутентификации от угроз?

- Введение

- Фундаментальные принципы аутентификации устройств

- 2.1. Конфиденциальность

- 2.2. Защита от спуфинга

- 2.3. Отказоустойчивость

- 2.4. Ответственность устройства

- Методы аутентификации устройств

- 3.1. На основе ключей

- 3.2. Сертификаты X.509

- 3.3. Геолокационная аутентификация

- 3.4. Взаимная аутентификация

- 3.5. Репутационная аутентификация

- 3.6. Протоколы безопасности

- Практические аспекты аутентификации устройств

- Взгляд в будущее

- Выводы

Введение

В эпоху четвёртой промышленной революции, «умных» городов и массового внедрения IoT проблематика информационной безопасности становится особенно острой. В отсутствие адекватной проверки устройств хакеры могут проникать в промышленные сети, информационные системы объектов энергетики и транспорта, парализовывая работу электростанций, систем управления движением, производственных линий.

Для защиты от этих угроз существует аутентификация устройств, т. е. процесс проверки их подлинности при подключении к сети или сервису. Он предотвращает обмен данными с поддельными сущностями.

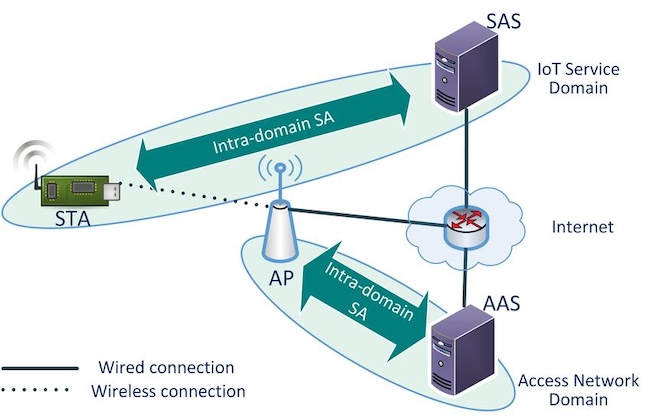

Рисунок 1. Схема аутентификации устройств в сети интернета вещей (IoT Authentication Architecture)

На рисунке показаны: IoT-устройство (STA), точка доступа (AP), сервер аутентификации (AAS), сервер авторизации (SAS), домены сети доступа и IoT-сервисов, проводные и беспроводные соединения, демонстрирующие процесс внутридоменной ассоциации безопасности (Intra-domain SA).

Фундаментальные принципы аутентификации устройств

Аутентификация устройств в IoT, корпоративных сетях, облачных инфраструктурах держится на четырёх принципах:

- Защита доступа к аутентификационным данным (конфиденциальность).

- Обеспечение целостности аутентификационной информации (защита от спуфинга).

- Надёжность работы аутентификационных систем (отказоустойчивость).

- Подтверждение выполненной аутентификации (ответственность устройства).

В современных реалиях этих принципов достаточно для построения надёжной системы аутентификации.

Конфиденциальность

Принцип конфиденциальности обеспечивает защиту аутентификационных данных от перехвата и изменения при передаче, гарантируя их безопасность даже в незащищённых сетях. Для его реализации применяются криптографические методы.

Во-первых, это симметричное шифрование. Режим аутентифицированного шифрования AES-GCM даёт одновременно конфиденциальность и целостность данных. Из плюсов — высокая производительность за счёт возможности параллелизации и защита от атак с определителем корректности криптографического дополнения (padding oracle).

Из альтернатив — комбинация потокового шифра XChaCha20 с аутентификатором Poly1305. Этот метод даёт высокую производительность шифрования на современных процессорах для ПК и мобильных устройств, а также приемлемую скорость на микроконтроллерах и устройствах IoT. Кроме того, он устойчив к кеш-атакам.

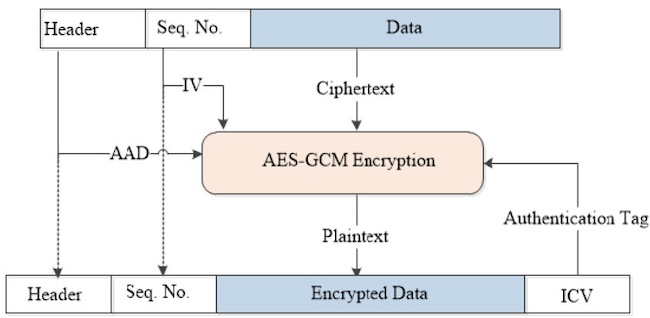

Рисунок 2. Процесс шифрования данных с использованием режима AES-GCM

Эта схема показывает входные данные («Header», «Seq. No.», «Data»), процесс шифрования, получение зашифрованного текста («Ciphertext») и тега аутентификации («Authentication Tag»), а также структуру выходных данных («Header», «Seq. No.», «Encrypted Data», «ICV»).

Во-вторых, это асимметричное шифрование:

- Схема цифровой подписи Ed25519 на основе кривых Эдвардса. За счёт математических свойств этих кривых, позволяющих эффективно выполнять операции скалярного умножения, а также использования 128-битных полей при построении кривой гарантируется высокая скорость генерации и проверки подписей при компактном размере ключа в 256 бит. Ed25519 устойчива к атакам по сторонним каналам и не подвержена уязвимостям, характерным для ECDSA. Благодаря этому она находит применение в протоколах и приложениях, где требуются высокая производительность и компактность, например в SSH, OpenPGP, криптовалютах.

- Протокол обмена ключами X25519 на основе кривой Curve25519. Обеспечивает совершенную прямую секретность (PFS) при использовании в протоколах типа TLS: даже если долговременные ключи скомпрометированы, не получится расшифровать ранее перехваченный трафик сессий, так как для каждой сессии генерируются новые сеансовые ключи, которые удаляются после завершения сессии. Применяется в защищённых версиях протоколов SSH, TLS, IPsec для обмена ключами и установления соединений.

В-третьих, для усиления защиты данных используются протоколы без разглашения (Zero-Knowledge Proof). Они помогают реализовать безопасную передачу зашифрованных данных по сети. Технологии наподобие Secure Enclave или Trusted Platform Module (TPM) применяются для хранения криптографических ключей в изолированной среде. Также есть многофакторная аутентификация (MFA) с аппаратными токенами для дополнительной защиты.

Защита от спуфинга

Защита от спуфинга критически важна для безопасности информационных систем. Число инцидентов компрометации корпоративных данных из-за перехвата и изменения информации хакерами постоянно растёт. Это привело к росту числа взломов и случаев ошибочной блокировки доступа.

Для противодействия этим угрозам созданы криптографические хеш-функции SHA-256 и SHA-3. Они генерируют уникальные цифровые отпечатки (хеши) для каждого блока данных. Это гарантирует целостность передаваемой информации, так как любое изменение приведёт к несовпадению значений. Данное несоответствие будет выявлено при проверке на принимающей стороне.

Также применяются коды аутентификации сообщений (MAC) для верификации источника данных. Например, HMAC-SHA256 основан на симметричном ключе, известном только отправителю и получателю. Это однозначно подтверждает факт отправки сообщения настоящим отправителем, без возможности подмены по пути.

Чтобы гарантировать целостность, аутентификацию и невозможность отказа от авторства передаваемых сообщений, созданы цифровые подписи RSA-PSS и ECDSA. Они построены на основе асимметричной криптографии с использованием пары ключей — открытого и закрытого. Это позволяет любому проверить, что сообщение было подписано закрытым ключом отправителя и не менялось после подписания. При этом отправитель не сможет отказаться от факта подписи, так как только он обладает закрытым ключом.

Без проверки целостности и подлинности данных аутентификации хакеры могут получить несанкционированный доступ или заблокировать настоящих пользователей. Поэтому обеспечение целостности — фундаментальный принцип информационной безопасности.

Для проверки целостности применяются сравнение хешей отправителя и получателя, верификация MAC общим секретным ключом, проверка ЭЦП открытым ключом отправителя, защищённые протоколы передачи (TLS / SSL), временные метки и одноразовые номера против атак с воспроизведением (replay).

Эти меры обеспечивают постоянство данных аутентификации при передаче, что считается базовым требованием по части безопасности.

Отказоустойчивость

Сбои в работе механизмов аутентификации могут привести к критическим последствиям — от потери доступа пользователей до полной остановки корпоративных процессов.

Здесь на помощь приходят:

- Распределённые системы аутентификации с балансировкой нагрузки.

- Резервирование ключевых компонентов инфраструктуры (серверы, базы данных, каналы связи).

- Механизмы автоматического восстановления после сбоев (failover).

- Кеширование аутентификационных данных на стороне клиентов для работы в офлайн-режиме.

- Мониторинг и проактивное обнаружение проблем в работе систем аутентификации.

Ответственность устройства

Этот принцип обеспечивает неотрекаемость устройства от факта прохождения процедуры аутентификации. Он критически важен для расследования инцидентов и предотвращения мошенничества.

Для его реализации применяются цифровые подписи на основе асимметричной криптографии (RSA, ECDSA), метки времени, привязанные к каждому акту аутентификации, а также защищённые от компрометации логи аудита всех операций проверки подлинности и аппаратные модули безопасности (HSM) для надёжного хранения ключей. Следует также упомянуть применение технологии доверенной загрузки (Secure Boot) для гарантии целостности ПО устройства.

Здесь важно гарантировать уникальность идентификаторов устройств и невозможность их компрометации. Для этого применяются криптографически стойкие генераторы случайных чисел и механизмы привязки идентификаторов к аппаратному обеспечению (например, PUF — физически неклонируемые функции).

Методы аутентификации устройств

Можно выделить шесть основных методов аутентификации устройств: на основе ключей, сертификатов X.509, токенов, геолокации, взаимной и репутационной проверки.

На основе ключей

В современных IoT-инфраструктурах и облачных средах критически важно соблюдать надёжную идентификацию и аутентификацию устройств. Какие методы решают эту задачу? Например, протокол SSH (Secure Shell). Этот протокол применяется для защищённого удалённого доступа к системам. Процесс работает так:

- Администратор генерирует пару ключей RSA (4096 бит) на рабочей станции.

- Открытый ключ копируется на целевой сервер в файл «~/.ssh/authorized_keys».

- При подключении клиент подписывает случайный проверочный запрос (challenge) от сервера закрытым ключом. Сервер проверяет подпись открытым ключом из «authorized_keys».

Этот метод исключает передачу паролей по сети и устойчив к атакам методом перебора. Чтобы не управлять ключами тысяч пользователей и серверов вручную, в корпоративных средах применяют SSH-сертификаты. Это электронные документы, которые выдаются центром сертификации (CA) организации и подтверждают принадлежность открытых ключей пользователей. CA создаётся для того, чтобы подписывать пользовательские ключи. Серверы настраиваются на доверие к этому CA, чтобы принимать только сертифицированные ключи.

Таким образом, любой пользователь с валидным сертификатом сможет аутентифицироваться на любом корпоративном сервере без предварительной настройки. Это упрощает управление доступом в больших инфраструктурах. А вот симметричная аутентификация используется уже в протоколах беспроводной связи, таких как WPA2-PSK для Wi-Fi. Здесь устройство и точка доступа имеют общий ключ. При соединении выполняются обмен случайными одноразовыми кодами (nonce) и вычисление временных ключей шифрования на их основе.

Этот метод особенно хорошо применим в домашних и небольших офисных сетях, но требует защиты от атак с подбором пароля по словарю (bruteforce). Брутфорс нацелен на простой перебор всех возможных комбинаций символов, чтобы угадать пароль. Такие атаки рассчитаны на слабые пароли, которые легко подобрать.

Сертификаты X.509

Сертификаты X.509 — широко используемый для аутентификации в современных сетях стандарт. Почему они так популярны? Здесь используется криптографический стандарт X.509 ITU-T для инфраструктуры открытых ключей (PKI). Он даёт надёжный способ подтвердить подлинность сущности (сервера, устройства, пользователя) через цифровые сертификаты.

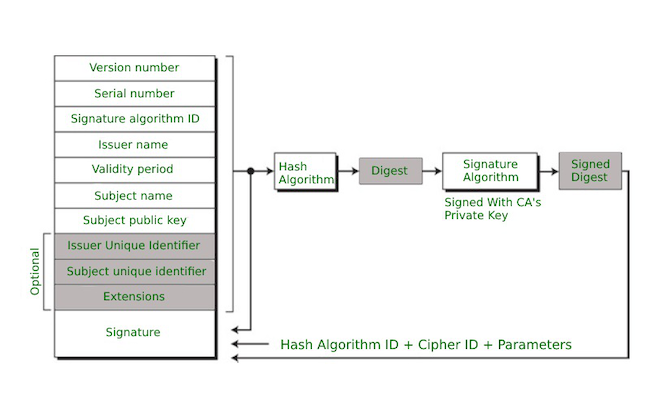

Рисунок 3. Структура сертификата X.509 с основными полями

Эта схема показывает базовые компоненты сертификата: версию (Version number), серийный номер (Serial number), алгоритм подписи (Signature algorithm ID), информацию об издателе (Issuer name) и субъекте (Subject name), период действия (Validity period), данные открытого ключа (Subject public key), расширения (Extensions) и подпись сертификата (Signature).

Как выглядит процесс аутентификации с помощью сертификатов X.509 в протоколе TLS:

- Клиент отправляет запрос ClientHello, указывая поддерживаемые алгоритмы.

- Сервер отвечает откликом ServerHello, выбирая алгоритмы, и отправляет свой сертификат.

- Клиент верифицирует сертификат сервера: проверяет цифровую подпись, используя открытый ключ издателя, валидирует цепочку до корневого CA, проверяет срок действия и наличие / отсутствие сигнала об отзыве сертификата (через OCSP или CRL), а также соответствие имени домена.

- Если верификация успешна, клиент генерирует сессионный ключ, шифрует его открытым ключом сервера и отправляет серверу.

- Сервер расшифровывает сессионный ключ своим закрытым ключом.

- Теперь обе стороны имеют общий сессионный ключ для шифрования дальнейшего обмена.

Для IoT-устройств часто используются облегчённые протоколы, такие как DTLS (Datagram TLS), адаптирующий TLS для работы поверх UDP. Это критически значимо для устройств с ограниченными ресурсами и нестабильным подключением. Сертификаты X.509 применяются для безопасной аутентификации устройств и здесь.

Ещё один способ усилить защиту — использовать токены безопасности. Это физические или виртуальные устройства, которые генерируют одноразовые пароли (OTP) или криптографические ключи. Они реализовывают двухфакторную аутентификацию (2FA), требуя подтверждения владения токеном в дополнение к обычному паролю.

Примеры аппаратных токенов — RSA SecurID (генерирует новый 6-значный код каждые 60 секунд), YubiKey (USB-устройство, поддерживающее FIDO U2F, FIDO2, OTP, PIV).

Популярные программные токены — Google Authenticator (алгоритм Time-based One-Time Password, TOTP), Authy (поддерживает TOTP и HMAC-based One-Time Password, HOTP).

Алгоритм TOTP (RFC 6238) работает так:

- Устройство и сервер имеют общий секретный ключ Shared Secret (обычно — 16–20 байт).

- Определяется интервал Time Step (обычно — 30 секунд).

- Для генерации OTP текущее время округляется до Time Step, вычисляется HMAC-SHA1 для общего ключа и текущего времени, берутся младшие 31 бит результата, и это число преобразовывается в 6-значный код.

Без сертификатов X.509 и токенов безопасности IoT-устройства становятся уязвимыми для несанкционированного доступа, перехвата данных, спуфинга, MitM- и DDoS-атак.

Геолокационная аутентификация

Геолокационная аутентификация использует триангуляцию, позиционирование и сенсоры близости (proximity) для верификации координат устройства. GPS, мобильные сети, Wi-Fi и Bluetooth формируют единый геопозиционный отпечаток, позволяющий подтвердить физическое местонахождение устройства при попытке аутентификации.

Подлинность запроса подтверждается путём анализа привязки к локации, маршруту перемещения и идентификаторам беспроводных сетей. Протоколы EAP-SIM и EAP-AKA верифицируют сим-карту по криптоключу, сопоставляя данные с HSS оператора. Это делается для предотвращения несанкционированного доступа с поддельных или украденных устройств.

Технологии NFC, UWB и BLE делают так, чтобы устройства проходили proximity-аутентификацию по измерению дистанции до доверенных меток. Точность геопозиционирования варьируется от нескольких метров для GPS и мобильных сетей до сантиметров для UWB. Это позволяет ограничивать доступ к ресурсам на основе точного физического местоположения.

Одной из главных угроз для геолокационной аутентификации считается спуфинг координат. Это такой метод атаки, когда хакер подделывает геоданные устройства, чтобы обмануть систему и получить доступ. Успешные атаки такого рода приводят к утечкам конфиденциальной информации и финансовым потерям для пострадавших организаций.

Для противодействия этим угрозам применяются комплексные методы проверки местоположения. Например, комбинированная верификация по GPS, Wi-Fi, BLE-маячку и Cell ID обеспечивает надёжное подтверждение подлинности устройства по фактическим координатам. Это усложняет фальсификацию геоданных для злоумышленников.

Кроме того, шифрование каналов передачи помогает защитить конфиденциальность пользователей от отслеживания перемещений.

Таким образом, геолокационная аутентификация формирует многофакторный периметр безопасности, связывающий цифровую идентичность с физическим окружением. Это помогает оперативно выявлять компрометацию по аномалиям местоположения и своевременно блокировать несанкционированный доступ за пределами доверенных зон. Внедрение таких методов значительно повышает защищённость современных информационных систем.

Взаимная аутентификация

Без надёжной взаимной аутентификации хакеры могут перехватывать трафик, подменять сообщения или выдавать себя за подтверждённых участников коммуникации.

Чтобы этого не допустить, протоколы безопасности SSL / TLS, Kerberos и др. реализовывают механизмы взаимной аутентификации.

Протоколы SSL / TLS с обменом сертификатами X.509 обеспечивают двустороннюю проверку подлинности клиента и сервера. Сервер показывает свой сертификат для подтверждения своей идентичности, а клиент, в свою очередь, может использовать свой сертификат для аутентификации на сервере. Это защищает от атак:

- С посредником (Man-in-the-Middle, MitM), когда злоумышленник перехватывает трафик и пытается выдать себя за одну из сторон.

- С дубликатом (Evil Twin), при которых хакер клонирует легитимную точку доступа Wi-Fi для перехвата данных.

- С отчуждением SSL (SSL Stripping), когда атакующий пытается понизить защищённое HTTPS-соединение до незащищённого HTTP.

В корпоративных сетях часто применяется протокол Kerberos. Он использует систему билетов и временных меток для взаимной аутентификации клиентов и серверов. Клиент запрашивает билеты у центра их выдачи (KDC) и использует их для доступа к сервисам. У билетов ограниченный срок действия, и шифруются они с помощью секретных ключей, известных только участникам транзакции. Это обеспечивает надёжную идентификацию пользователей и защиту от несанкционированного доступа.

Репутационная аутентификация

В основе репутационной аутентификации лежат следующие концепции:

- Web of Trust (WoT) в PGP. Участники перекрёстно подписывают криптографические ключи друг друга. Это формирует децентрализованную сеть доверия.

- Алгоритмы подобные PageRank. Они ранжируют узлы в сети по их связям и репутации.

- PKI на базе блокчейна. Консенсусные протоколы безопасно распространяют публичные ключи. Блокчейн делает инфраструктуру открытых ключей неизменяемой и прозрачной.

Для репутационной аутентификации используются фреймворки KeyNote и EigenTrust, позволяющие собирать и анализировать репутационные данные из разных источников. Они динамически меняют уровень доверия к участникам на основе их поведения и истории взаимодействий. Так система адаптируется к меняющимся угрозам.

Интеграция таких технологий даёт возможность создать адаптивную систему оценки доверия, устойчивую ко взлому отдельных узлов, чтобы она могла развиваться при появлении новых угроз.

Такой подход обеспечивает гибкий контроль доступа и снижает риски НСД. Он позволяет строить динамические модели доверия, адаптированные под конкретную систему и учитывающие изменения в отношениях между участниками.

Протоколы безопасности

В корпоративных сетях и IoT-инфраструктурах имеет смысл организовать аутентификацию через протоколы IPsec и SSH. Это предупредит угрозы перехвата данных, подмены устройств и несанкционированного доступа. В итоге не придётся беспокоиться о безопасности коммуникаций на сетевом и прикладном уровнях.

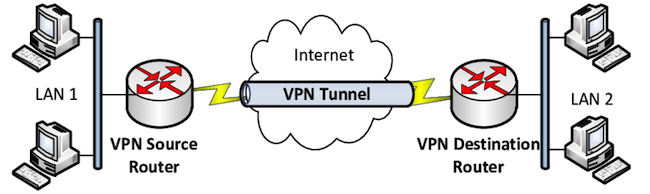

Рисунок 4. VPN-соединение через интернет между двумя локальными сетями

IPsec и SSH формируют фундамент защищённого взаимодействия, предоставляя ключевые сервисы безопасности:

- Взаимная аутентификация общающихся сторон.

- Шифрование для конфиденциальности трафика.

- Проверка целостности и подлинности данных.

- Защита от атак с повторным воспроизведением.

Чтобы не утруждаться ручным управлением криптоключами в больших сетях, используют протокол IKE. Он автоматизирует создание, распределение и смену ключей для IPsec. В итоге можно эффективно защищать соединения без лишних сложностей.

Noise Protocol Framework — это набор криптографических инструментов для создания собственных протоколов безопасности. Он позволяет гибко настраивать защиту под конкретные задачи.

Ещё один полезный протокол — QUIC. Он объединяет функции TCP и TLS для быстрого установления защищённых соединений. Это снижает задержки и повышает скорость обмена данными в нестабильных сетях.

Если внедрить все эти протоколы в единой среде, аутентификация устройств будет надёжно защищена на всех уровнях. Это создаст комплексную экосистему безопасности, готовую противостоять разнообразным угрозам и оптимизированную под современные сценарии использования. Взаимодействие протоколов и фреймворков даст многоуровневую защиту коммуникаций без ущерба для производительности.

Практические аспекты аутентификации устройств

Как грамотно внедрить протоколы в единую среду и не допустить несанкционированного доступа хакеров?

Комплексный подход к защите

Для создания правильной системы аутентификации устройств, при которой хакеры не смогут получить несанкционированный доступ, необходим комплексный многоуровневый подход. Он должен сочетать современные протоколы, адаптивные алгоритмы и отказоустойчивую инфраструктуру. Например, такой стек может включать в себя:

- Протоколы аутентификации FIDO2, WebAuthn, OAuth 2.0, SAML.

- Адаптивные алгоритмы на базе машинного обучения для анализа поведения.

- Распределённую отказоустойчивую инфраструктуру на базе Kubernetes.

- Защищённое управление криптографическими ключами и сертификатами.

- Проактивное моделирование и анализ угроз безопасности.

Этого должно хватать для безопасного доступа устройств ко критически важным ресурсам и данным.

Многофакторная аутентификация

Фундаментом грамотно построенной проверки подлинности всегда служит многофакторная аутентификация (MFA). Стандарты FIDO2 и WebAuthn позволяют реализовать надёжную MFA с использованием аппаратных токенов вроде YubiKey или Google Titan в связке с биометрией пользователя. Это намного безопаснее обычных паролей, которые можно подобрать, украсть или использовать повторно после компрометации.

Zero Trust и сегментация сети

Традиционная модель периметровой защиты по принципу «все, кто внутри, — доверенные» уже не работает. Нужно исходить из предположения, что сеть уже скомпрометирована. Поэтому в корпоративных сетях используется архитектура Zero Trust, где по умолчанию не доверяют никому.

Инфраструктура разбивается на изолированные сегменты, а доступ к ресурсам ограничивается через программно определяемый периметр (SDP). Так можно ограничить зону поражения при взломе отдельного узла. Для минимизации рисков в области привилегированного доступа применяют решения класса PAM (Privileged Access Management). Они позволяют гранулярно контролировать и автоматизировать выдачу привилегий через системы вроде Ansible или Terraform.

Отказоустойчивость

Сбои и простои сервисов аутентификации открывают хакерам лазейки в корпоративную сеть. DDoS-атаки могут полностью парализовать процессы аутентификации и нарушить бизнес-процессы. Поэтому так важно обеспечить отказоустойчивость и надёжность инфраструктуры аутентификации.

В хорошо защищённых системах аутентификации используют:

- Географическое распределение и балансировку нагрузки через GSLB.

- Асинхронную репликацию данных между узлами через Kafka или RabbitMQ.

- Оркестровку контейнеров с помощью Kubernetes.

- Паттерны Circuit Breaker и Auto-Scaling для обработки пиковых нагрузок и автоматического восстановления после сбоев.

В таком стеке GSLB отвечает за балансировку нагрузки и географическое распределение, Kafka / RabbitMQ — за асинхронную репликацию данных, Kubernetes — за согласованную работу контейнеров и автоматическое масштабирование, а паттерн Circuit Breaker защищает от каскадных сбоев. В итоге система аутентификации становится устойчивой к большинству технических неполадок, DDoS-атак и пиковых нагрузок.

Защита ключей и сертификатов

Чтобы защитить криптографические ключи и сертификаты от компрометации, используют инфраструктуру открытых ключей (PKI) и аппаратные модули безопасности (HSM).

Для развёртывания PKI применяют специализированные решения, такие как EJBCA или Microsoft ADCS. В свою очередь, HSM обеспечивают физическую защиту ключей от кражи и несанкционированного использования.

Рисунок 5. Аппаратный модуль безопасности (HSM) для защиты криптографических ключей

Кроме того, для управления жизненным циклом сертификатов применяют автоматизированные процессы на базе протокола ACME и систем Certificate Transparency. Они позволяют быстро выпускать, отзывать и ротировать сертификаты, снижая риски связанные с просроченными или скомпрометированными сертификатами.

Взгляд в будущее

Квантовые компьютеры поставят под угрозу традиционные методы аутентификации устройств. Асимметричные алгоритмы наподобие RSA и ECC, используемые в цифровых подписях и инфраструктуре открытых ключей, могут быть взломаны квантовыми вычислениями. Это позволит злоумышленникам подделывать цифровые сертификаты для маскировки вредоносных устройств под легитимные, внедрять неопознаваемые закладки и бэкдоры в прошивки и драйверы, перехватывать и расшифровывать защищённый трафик устройств, компрометировать целые сети «умных» гаджетов, превращая их в ботнеты.

Ущерб от компрометации устройств в «умных» городах, на производствах, в энергетике и транспорте может измеряться миллиардами долларов и миллионами человеческих судеб.

Чтобы защититься от квантовых атак, нужно срочно переходить на постквантовые алгоритмы аутентификации устройств:

- Квантово-устойчивые цифровые подписи на основе хеш-функций и решёток.

- Постквантовые протоколы выработки общего ключа, такие как NewHope и NTRU.

- Симметричные схемы аутентификации с увеличенной длиной ключа (256+ бит).

Параллельно можно усиливать классические методы проверки подлинности устройств — например, внедрять технологии доверенной загрузки и измерения целостности встроенного ПО, а также децентрализованные PKI на базе блокчейна для распределённого управления сертификатами устройств, плюс делать аттестацию на соответствие отраслевым стандартам безопасности (Common Criteria, FIPS).

Выводы

Для надёжной защиты критически важных инфраструктур и пользовательских данных необходим комплексный многоуровневый подход. Он должен включать в себя современные криптографические алгоритмы (AES, SHA-3, ECDSA) для обеспечения конфиденциальности, целостности, доступности и неотказуемости, инфраструктуру открытых ключей (PKI) и сертификаты X.509 с возможностью перехода на постквантовые алгоритмы, адаптивные методы на базе машинного обучения (ML) и поведенческой аналитики (UBA) для выявления аномалий и потенциальных угроз.

Кроме того, важно использовать отказоустойчивые распределённые архитектуры с оркестровкой контейнеров и автоматическим восстановлением для непрерывной доступности, аппаратные модули безопасности (HSM) для защиты криптографических ключей и управления жизненным циклом сертификатов по протоколу ACME, многофакторную аутентификацию (MFA) на базе аппаратных токенов и биометрии по стандартам FIDO2 и WebAuthn, а также архитектуру Zero Trust и сегментацию сети для минимизации рисков и ограничения зоны поражения при компрометации отдельных узлов.