Машинное обучение и искусственный интеллект находят всё больше применений в кибербезопасности: обеспечивают передовые механизмы обнаружения угроз, анализ уязвимостей и предотвращение атак. Эксперты AM Live обсудили, как ИИ и ML меняют ландшафт ИБ, какую пользу можно извлечь из больших языковых моделей (LLM).

- Введение

- Как применить машинное обучение и искусственный интеллект в ИБ?

- В каких условиях можно доверять результатам работы ML?

- Прогнозы экспертов

- Выводы

Введение

Для того чтобы осуществлять более массовые и совершенные атаки, будь то фишинг, мошенничество или эксплуатация уязвимостей, киберпреступники активно осваивают машинное обучение (ML) и генеративный искусственный интеллект (GenAI). Соответственно, такие технологии должны быть и в арсенале защитников.

Например, ChatGPT и DeepSeek могут обрабатывать большие объёмы данных, выявляя аномалии и потенциальные угрозы, помогают быстро классифицировать угрозы, анализировать, есть ли в исходном коде уязвимости, генерировать сценарии атак для тестирования защитных механизмов.

Рисунок 1. Эксперты в студии AM Live

Участники эфира:

- Владислав Тушканов, руководитель группы машинного обучения, «Лаборатория Касперского».

- Вадим Куликов, руководитель отдела машинного обучения, SkyDNS.

- Сергей Померанцев, владелец продукта Avanpost SmartPAM, Avanpost.

- Алексей Дашков, директор Центра развития продуктов, NGR Softlab.

- Николай Лыфенко, руководитель группы анализа трафика, Positive Technologies.

- Сергей Нестерук, эксперт по безопасности ML, Yandex Cloud.

Ведущий и модератор эфира — Алексей Горелкин, генеральный директор Phishman.

Как применить машинное обучение и искусственный интеллект в ИБ?

Внутренняя LLM очень полезна для компании. ML помогает снижать нагрузку на операторов, подсвечивать самое интересное, обнаруживать атаки, предотвращать любую возможность недопустимых событий. Николай Лыфенко отметил, что важно понимать и учитывать критерии применимости и эффективности таких технологий.

Николай Лыфенко, руководитель группы анализа трафика, Positive Technologies

Для нужд машинного обучения требуется уметь автоматически собирать данные, модифицировать их, делать синтетические данные, когда это необходимо. Невозможно выполнять все задачи вручную, это слишком дорого. Вместе с тем нецелесообразно полностью автоматизировать процесс: готовых датасетов для конкретной задачи обычно нет. Сергей Нестерук предложил искать какой-то компромисс.

Чтобы собрать датасеты, нужны экспертные знания в области ИБ, ресурсы на обучение и развёртывание моделей. Можно использовать облачные сервисы или API готовых моделей. Стоит помнить, что во многих задачах есть специфические требования, которые не позволяют использовать любую абстрактную модель машинного обучения.

Специалисту, который будет внедрять ИИ, предстоит учесть множество компромиссов: точность или производительность, сложность или интерпретируемость, универсальность или специфичность.

Сергей Нестерук, эксперт по безопасности ML, Yandex Cloud

Алексей Дашков дополнил, что ML и AI предназначены для автоматизации деятельности. При машинном обучении решаются три основные задачи: классификация, кластеризация и прогнозирование.

По мнению Сергея Померанцева, уже сейчас некоторые вещи в ИБ удаётся сделать только с ИИ, например предложить новые технологии фильтрации спама. Раньше на подготовку фишинговых атак уходил один день, теперь требуется один час, так как информация обрабатывается искусственным интеллектом. Такое сравнение привёл Вадим Куликов.

Алексей Горелкин рассказал о недавнем проекте по распознаванию дипфейков, который МВД заказало у одной российской компании. Результаты показали, что хотя и не всегда, но всё-таки можно бороться с одной ИИ-моделью при помощи другой.

Алексей Горелкин, генеральный директор Phishman

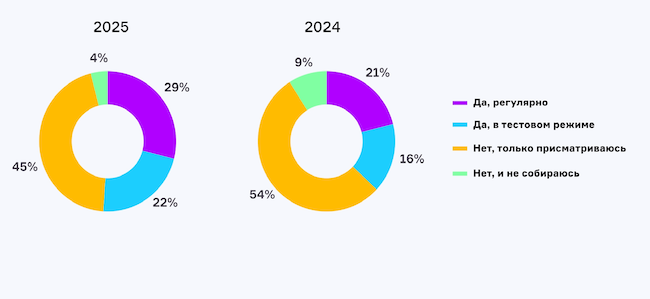

Первый опрос в прямом эфире AM Live показал, применяют ли компании машинное обучение и инструменты ИИ в работе. Только присматриваются 45 %, регулярно обращаются к тому и другому 29 %, пробуют пока в тестовом режиме 22 %. Вообще не планируют задействовать 4 % ответивших.

Рисунок 2. Используете ли вы машинное обучение и инструменты ИИ в повседневной работе?

Эксперты ответили на блиц-вопрос, в решении каких задач модели ML обгоняют человека по эффективности и скорости.

Владислав Тушканов:

«Это задачи, в которых нужно делать одно и то же, где нужен большой контекст. Например, кластеризация вредоносных объектов».

Вадим Куликов:

«Решается проблема большого количества данных, которые нужно обрабатывать. Для крупных компаний это вопрос снижения фонда оплаты труда и повышения эффективности, а для маленьких — способ выжить на рынке и конкурентное преимущество».

Сергей Померанцев:

«По скорости работы человеческий мозг проигрывает, поэтому и был создан искусственный интеллект. Но человек выигрывает в задачах, где нужен глубокий анализ и привлечение дополнительного контекста, который машине неизвестен, например глубокое расследование происшествий».

Алексей Дашков:

«Поведенческая аналитика. Эту задачу человек вручную не решит. Анализ действий пользователей, сетевого трафика — направление, которое всегда будет востребованным для ML».

Николай Лыфенко:

«Модели ML могут быть асессорами, разметчиками данных, что снижает нагрузку на экспертов».

Сергей Нестерук:

«Над инцидентом могут работать много людей посменно. Им приходится изучать всё, что происходило на рабочем месте без них. ML допустимо использовать для суммаризации тикетов, чтобы сотрудник сразу видел нужную информацию».

Прогнозирование и раннее предотвращение кибератак

Вадим Куликов рассказал об опыте своей компании, которая является крупнейшим DNS-резолвером, через него проходит много запросов. Эти данные можно собирать и логировать с помощью Passive DNS и в дальнейшем обрабатывать их. Накапливается информация о доменных именах и IP-адресах, ответы серверов, метаданные. Таким образом получается находить определённые схожие домены ещё на этапе их создания.

После компрометации хотя бы одного домена DGA-сети (алгоритмы, используемые вредоносными программами для генерации большого количества случайных доменных имён) и анализа поведения пользователей можно обнаружить другие домены той же сети ещё в день их регистрации. В результате они оказываются заблокированными до того, как злоумышленники задействуют подозрительные ресурсы. Как показывает практика, благодаря описанному подходу удаётся заблаговременно защитить пользователей.

Вадим Куликов, руководитель отдела машинного обучения, SkyDNS

Сергей Померанцев считает, что правильное управление доступом позволяет предотвратить атаки как можно раньше. Современные IdM давно научились анализировать, есть ли аномалии во множестве учётных записей. Кроме того, целесообразно применять ИИ для того, чтобы избежать SoD-конфликтов. Также искусственный интеллект полезен, когда приходится выявлять аномалии в действиях привилегированных пользователей и подсвечивать их как риск.

Есть стандартное поведение пользователя, и есть отклонения, об этом напомнил Алексей Дашков. С помощью ИИ система антифрода приобретает способность анализировать поведение пользователей, а на этапе появления аномалий эффективно отслеживает и анализирует деятельность службы каталогов. Также ИИ может подсказать, как правильно сформировать группы безопасности в каталоге и какие учётные записи поместить туда.

Алексей Дашков, директор Центра развития продуктов, NGR Softlab

Сергей Нестерук уверен, что утечки могут происходить из-за действий сотрудников или размещения данных в неправильном месте. С помощью ML удаётся выяснить, где лежат персональные, банковские, медицинские сведения или другая конфиденциальная информация в S3-хранилищах (бакетах).

По мнению Владислава Тушканова, большие языковые модели можно применять для выделения информации из отчётов по кибератакам. Такая услуга востребована, потому что попадаются очень длинные и подробные отчёты. Кроме того, иногда они написаны на языке, которого аналитик не знает.

В рамках второго опроса зрители AM Live ответили, какой из сценариев использования машинного обучения в ИБ наиболее привлекателен для них. Большинство (32 %) выбрало прогнозирование и раннее предотвращение кибератак, за автоматизацию рутинных операций в SOC проголосовали 23 %, за обнаружение аномалий в действиях сотрудников — 21 %, обнаружение и фильтрацию вредоносного контента отметили 16 %.

Рисунок 3. Какой сценарий использования ИИ или ML в ИБ наиболее привлекателен?

Аутентификация и контроль доступа

Сергей Нестерук рассказал о применении ML на примере сервиса Access Transparency в Yandex Cloud. Для доступа к клиентским ресурсам сотрудники подключаются к бастионному хосту и получают права. Бастионный сервер логирует все события и сессии. Позже в центре мониторинга (SOC) все сеансы анализируются с помощью ML. Такая последовательность действий повышает прозрачность, полезна для быстрого реагирования. Кроме того, сотрудники SOC получают подробный анализ каждой сессии, как вспомогательный инструмент.

Сергей Померанцев вспомнил об аутентификации с помощью биометрии. Подобные задачи давно решаются с помощью искусственного интеллекта, но есть некоторые проблемы, которые затрудняют использование указанных технологий в корпоративном сегменте. С помощью искусственного интеллекта можно адаптировать сценарии аутентификации к динамическим угрозам, способным развиваться по сложным сценариям.

Сергей Померанцев, владелец продукта Avanpost SmartPAM, Avanpost

В каких условиях можно доверять результатам работы ML?

О том, что делает технологию ML достаточно зрелой, чтобы её можно было использовать в критическом сценарии (например, в детектировании с блокировкой), рассказал Владислав Тушканов. Кроме упомянутых ранее метрик и способов интерпретации есть ещё один компонент — мониторинг. Недостаточно взять модель и обучить её.

Для адекватной работы целесообразно задействовать специальные статистические методы, с помощью которых оценивается вероятность неправильных срабатываний модели. Надо стремиться к тому, чтобы доля ошибок была меньше, чем у людей. Приходится постоянно мониторить ситуацию, вкладывать ресурсы с целью перепроверять результаты и поддерживать уровень качества.

Владислав Тушканов, руководитель группы машинного обучения, «Лаборатория Касперского»

Николай Лыфенко предупредил, что в случае с блокировкой важен уровень критичности. Если используется ML, важна связка с экспертом и ручная валидация, интерпретируемость и выделение признаков.

Есть модели, которые выдают готовое решение, если уверены в полученном результате. При отсутствии гарантий они предупреждают, что данных недостаточно. Такой комментарий дал Алексей Дашков.

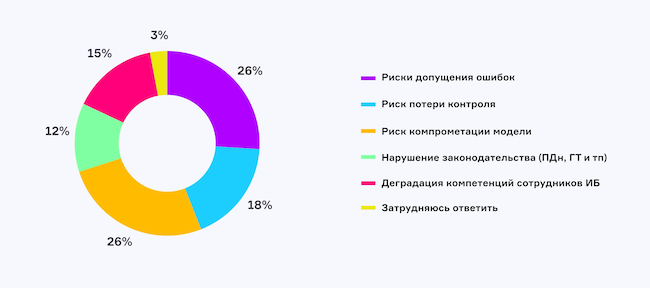

Третий опрос показал, что считают главным риском использования ML и ИИ в кибербезопасности зрители AM Live. Допущение ошибок и компрометация модели набрали по 26 % голосов. Потерю контроля отметили 18 %, на деградацию компетенций сотрудников ИБ указали 15 %, нарушение законодательства беспокоит 12 % опрошенных.

Рисунок 4. Какой главный риск использования ML и генеративного ИИ в кибербезопасности?

Прогнозы экспертов

Владислав Тушканов:

«На данный момент детектирование, определение вредоносности уже достаточно развиты. Далее только эволюционное развитие, улучшение, приспособление к новым разработкам. Нет уверенности, что генеративный ИИ кого-то заменит, но будет гораздо больше сценариев с повышением надёжности и способности моделей, особенно с возможностью держать длинный контекст в агентских сценариях».

Вадим Куликов:

«Демократизацией условий использования LLM, которую допустимо запускать на простом и слабом железе, можно сильно ускорить распространение ИИ в кибербезопасности».

Сергей Померанцев:

«LLM разовьются так, что позволят генерировать качественные синтетические датасеты, будет возможность с помощью одной нейросети обучать другую».

Алексей Дашков:

«Начнём переходить на аппаратные варианты обработки алгоритмов для работы моделей, так как с графическими картами сложно: модели требуют много ресурсов. В будущем обучение станет быстрее и проще, вес моделей окажется меньше, и у них появится возможность работать на носимых устройствах».

Николай Лыфенко:

«Переход к автоматизации, автопилотированию по принципу большой зелёной кнопки “сделать хорошо” неизбежен. Это достижимо с помощью ИИ-помощников».

Сергей Нестерук:

«Человеческие роли не исчезнут. Инструменты создаются для помощи людям, чтобы они могли делать свою работу лучше. Будет появляться больше мультимодальных данных, и в целом ожидается более глубокое проникновение новых технологий на основе ИИ и ML в сферу ИБ».

Четвёртый опрос показал, как изменилось мнение зрителей о применении ИИ в ИБ после эфира. Готовы тестировать и внедрять 44 %, убедились в его необходимости 32 %, считают пока далёким от реальности 23 %.

Рисунок 5. Каково ваше мнение о применении ИИ в ИБ после эфира?

Выводы

Искусственный интеллект и машинное обучение — это не просто инструменты, а стратегические активы, которые определяют будущее кибербезопасности. Их грамотное использование позволит создать более защищённое цифровое пространство.

Однако, как и любая технология, ИИ и ML сопряжены с рисками. Злоумышленники могут использовать эти инструменты для создания более сложных атак, что требует от специалистов по кибербезопасности постоянного совершенствования методов защиты.

В будущем развитие ИИ и ML в кибербезопасности пойдёт по пути создания более интеллектуальных, автономных и устойчивых систем. Эти технологии станут ключевыми элементами стратегии защиты данных, обеспечивая надлежащие условия как для бизнеса, так и для частных пользователей.

Телепроект AM Live еженедельно приглашает экспертов отрасли в студию, чтобы обсудить актуальные темы российского рынка ИБ и ИТ. Будьте в курсе трендов и важных событий. Для этого подпишитесь на наш YouTube-канал. До новых встреч!