Генеративный искусственный интеллект (ИИ) полезен при выполнении рутинных задач, вместе с тем часто игнорируются сопутствующие риски для общества. Мошенники уже используют нейросети в своих схемах, государства и корпорации вовлечены в «гонку вооружений» в этой сфере. Как подготовиться к вызовам нового мира?

- Введение

- Риски, порождаемые искусственным интеллектом

- 2.1. Риск утечки данных

- 2.2. «Галлюцинации» ИИ

- 2.3. Нарушение авторских прав

- 2.4. Экономические риски

- 2.5. Проблема «чёрного ящика»

- Использование нейросетей киберпреступниками

- Состязательное машинное обучение (Adversarial Machine Learning)

- Защита от рисков, создаваемых ИИ

- Выводы

Введение

Генеративный искусственный интеллект (ИИ) — технология, которая уже сегодня принципиально меняет правила игры в самых разных сферах. Джинн выпущен из бутылки: человечество стоит на пороге радикальных перемен, которые неизбежно затронут рынок труда, культуру, безопасность и многие другие аспекты общественной жизни.

Государства и корпорации по всему миру осознали колоссальный потенциал генеративного ИИ, о чём красноречиво свидетельствует, например, недавняя напряжённая конкуренция между ChatGPT и DeepSeek. Президент США Дональд Трамп объявил о «крупнейшем проекте инфраструктуры ИИ в истории», в котором участвуют OpenAI, SoftBank и Oracle. Речь идёт об инвестировании $500 млрд в масштабную инфраструктуру ИИ в США, предполагается создать 100 000 рабочих мест.

Риски, связанные с генеративным ИИ, также очень значительны: многие люди потеряют работу, пропаганда, дезинформация и мошенничество выйдут на новый уровень. Нередко это пугает даже бывших сторонников ИИ. Элиезер Юдковский, в прошлом известный популяризатор ИИ, изменил свою позицию, призвав к немедленному отключению ИИ.

Закрывать этот ящик Пандоры уже поздно. Дело в том, что отставание в этой отрасли сопряжено с ещё большими рисками, например с утратой конкурентоспособности в экономике, политике, культуре, науке. Даже если несколько стран согласуют мораторий на генеративный ИИ, страны, которые не будут связывать себя такими ограничениями, получат преимущество. А так как в эпоху геополитической и экономической турбулентности страны больше заботятся о своём суверенитете, чем о международном консенсусе, вряд ли все страны разом примут такой мораторий.

«Гонка вооружений» в области ИИ неотвратимо станет реальностью уже завтра. Соответственно, сейчас понимание особенностей и рисков использования генеративного ИИ имеет первостепенное значение.

Риски, порождаемые искусственным интеллектом

Риски, связанные с ИИ, весьма разнообразны. Перечислим наиболее существенные из них.

Риск утечки данных

Для обучения нейросетей часто нужны большие объёмы данных для обучения, которые могут включать конфиденциальную информацию пользователей (личную информацию, медицинские данные, финансовую информацию и многое другое). Если эти данные не были должным образом анонимизированы или обезличены, существует риск их прямого раскрытия.

Иногда востребованы технические данные о пользовательских устройствах, включая информацию из файлов cookie, журналы ошибок и производительности, языковые настройки системы. Такие данные могут быть весьма ценны для опытных злоумышленников, а значит, подобные утечки также создают большой риск.

Даже после анонимизации данных мощные нейросети могут восстанавливать конфиденциальную информацию, содержавшуюся в них изначально. Например, можно восстановить изображения лиц из «зашумлённых» данных, использованных для обучения модели распознавания лиц.

Сама модель нейросети может содержать информацию об обучающих данных. Атакующие могут анализировать архитектуру сети и её веса, чтобы извлечь конфиденциальные сведения. Это особенно актуально для моделей, которые обучаются на небольших наборах чувствительных данных.

Генеративный ИИ создаёт угрозы безопасности, не только частных данных, но и корпоративной и государственной информации. Подобные риски могут привести к тому, что компании запретят своим сотрудникам использовать сторонние нейросети для обработки внутренних данных.

«Галлюцинации» ИИ

«Галлюцинации» ИИ возникают, когда модели ИИ генерируют уверенные, но ошибочные ответы, не основанные на фактических данных. Эти «галлюцинации» могут проявляться в различных формах, включая искажение фактов, выдумывание событий или создание несуществующих источников информации. Искажение обуславливают недостаток качественных данных для обучения, сложность моделей и их интерпретация запросов.

Примечательно, что большие языковые модели с огромным количеством параметров могут быть склонны к более частым «галлюцинациям» из-за сложности управления всей информацией. Процесс генерации текста по природе стохастичен, и модель может выбрать не самый лучший вариант из возможных, даже если у неё есть доступ к правильной информации.

«Галлюцинации» ИИ представляют собой серьёзную проблему, особенно в таких областях, как медицина и юриспруденция. Использование недостоверной информации, сгенерированной ИИ, может привести к принятию ошибочных решений, имеющих серьёзные последствия.

Нарушение авторских прав

Обучение нейросетей требует огромных объёмов данных, значительная часть которых защищена авторским правом. Выявляя и воспроизводя закономерности этих данных, ИИ может генерировать контент, практически идентичный существующим произведениям. Это вызывает серьёзные вопросы о законности использования защищённого контента для обучения ИИ, об оригинальности и авторских правах на созданный им контент.

Существующая правовая база не содержит конкретных норм в отношении контента, сгенерированного ИИ. Дискуссионными остаются законность использования защищённых авторским правом материалов для обучения ИИ и нарушения авторских прав при использовании ИИ.

В России, США и других странах уже ведутся судебные разбирательства, призванные определить ответственность разработчиков, заказчиков и пользователей генеративного ИИ за возможные нарушения интеллектуальной собственности.

Экономические риски

Массовое применение генеративного ИИ чревато последствиями для рынка труда. Современные генеративные ИИ способны создавать тексты, изображения, аудио, видео, программный код. Хотя во многих частных аспектах нейросети всё ещё уступают человеку, множество людей рискуют потерять работу. Представьте, что вы годами учились создавать и редактировать видео, а теперь для этого достаточно сформулировать хороший промпт.

Более того, в далёкой перспективе генеративный ИИ, возможно, нарушит привычную логику общества потребления. Дело в том, что в рамках прежней модели капитализма человек производил товар или услугу, продавал её на рынке, а затем покупал другой товар или услугу. Всё хорошо, деньги циркулируют в экономике. Однако машина не пойдёт тратить деньги в кофейню, ресторан или бар, не будет покупать мебель или бытовую технику, — циркуляция денег в экономике будет нарушена.

Существуют также риски монополизации индустрии. Для поддержки необходимы немалые инвестиции в вычислительные мощности и инфраструктуру обработки данных, следовательно, такие траты могут себе позволить немногие игроки на рынке.

В ближайшие годы не следует переоценивать риски ИИ, это ещё раз показал недавний пример конкуренции между ChatGPT и DeepSeek. В разработку DeepSeek вложено всего 6 млн долларов, что значительно меньше, чем стоимость создания ChatGPT, на что потратили более 100 млн долларов. Так как большинство государств и корпораций осознают значимость этой технологии, конкуренция обещает быть ожесточённой. Когда же пыль осядет и из схватки выйдут немногочисленные победители, ситуация может измениться.

Рисунок 1. Падение акций из-за популярности DeepSeek

Проблема «чёрного ящика»

Проблема «чёрного ящика» в нейросетях — это фундаментальное ограничение, связанное с трудностями понимания и интерпретации процессов принятия решений в сложных моделях глубокого обучения. Несмотря на впечатляющие результаты, достигаемые современными нейросетями в различных областях, часто очень трудно объяснить, почему сеть приняла конкретное решение.

Нейросеть состоит из множества слоёв и миллионов параметров, её устройство слишком сложно для человеческого понимания. Нейросеть выступает как «чёрный ящик», механизмы функционирования которого неизвестны. Как можно регулировать отрасль, где не до конца ясно, как функционирует технология?

Непрозрачность создаёт серьёзные проблемы в различных сферах применения. Например, в медицине от точности диагноза зависит жизнь человека, невозможность объяснить решение нейросети неприемлема. Аналогичная ситуация вероятна в правовой сфере, где необходимо обосновать принятое решение. Для обеспечения безопасности автономного вождения важно понимать, почему система приняла то или иное решение в потенциально опасной ситуации.

Использование нейросетей киберпреступниками

Мошенники быстро увидели потенциал новой технологии и уже используют генеративный ИИ для разнообразных схем. Вот некоторые из них.

Дезинформация и распространение фейков

Нейронные сети, демонстрирующие впечатляющие возможности в плане генерации текста, изображений и видео, становятся всё более доступными. Кроме более широкого доступа к информации резко увеличивается риск их использования для распространения дезинформации и манипулирования общественным мнением.

Языковые модели допускают использование для автоматической генерации пропаганды, адаптированной под различные целевые аудитории. Фейковые новости, генерируемые нейросетью, могут быть использованы для манипулирования рынком, например путём распространения ложной информации о финансовом состоянии компаний или предстоящем экономическом кризисе.

Рисунок 2. Сгенерированная ИИ фейковая фотография Дональда Трампа с афроамериканцами (источник: BBC)

Ещё более опасны дипфейки — видео- и аудиозаписи, созданные с помощью ИИ и воспроизводящие внешность и голос реальных людей. Эти подделки настолько реалистичны, что их практически невозможно отличить от оригиналов. В дипфейке можно показать политика, произносящего оскорбительные или компрометирующие заявления, которых он никогда не делал. Это может нанести непоправимый ущерб его репутации и политической карьере.

Фишинговые атаки

Уже сегодня существуют разнообразные способы использования нейросетей для фишинговых атак. Например, нейросети создают очень убедительные персонализированные фишинговые письма, которые могут выглядеть как легитимные запросы на подтверждение личной информации.

Мошенники используют информацию из открытых источников, чтобы сделать письмо более правдоподобным. С помощью генеративного ИИ злоумышленники анализируют информацию о жертвах из социальных сетей. Для персонализированных фишинговых атак востребованы дипфейки с голосами родственников или коллег. Нейросети способны значительно увеличить скорость и масштаб фишинговых атак, отправляя тысячи писем за короткий промежуток времени.

Фейковые сервисы, которые с помощью генеративного ИИ выманивают у пользователей личные данные или даже криптовалюту. Также мошенники создают поддельные версии известных нейросетей (например, ChatGPT или DeepSeek), чтобы собирать конфиденциальную информацию пользователей.

Создание вредоносного кода

Пока генеративный ИИ способен создавать только простой код, но развитие данной функции может привести к неоднозначным последствиям. Если злоумышленники используют нейросети для автоматического создания новых видов вредоносного кода, его будет сложнее обнаружить и обезвредить традиционными методами. Мошенники могут задействовать нейросети для поиска уязвимостей в системах безопасности и создания эксплойтов.

Один из главных рисков заключается в снижении порога входа для создания вредоносного кода. Раньше для написания эффективного вируса или трояна требовались глубокие знания программирования и низкоуровневых технологий. Нейросети, способные генерировать код на основе естественного языка, позволяют создавать вредоносные программы даже людям с минимальными навыками в программировании.

Мейнстримные нейросети вряд ли будут отвечать на запросы злоумышленников, но гении даркнета наверняка уже тестируют своё новое оружие. Достаточно сформулировать задачу на естественном языке, например: «Напиши программу, которая будет красть пароли из браузера Chrome», — и нейросеть сгенерирует соответствующий код.

Массовое распространение инструментов, генерирующих вредоносный код на основе ИИ, приведёт к экспоненциальному росту количества кибератак. Злоумышленники смогут создавать огромное количество вариаций вредоносных программ, обходя традиционные системы защиты, основанные на сигнатурном анализе. Кроме того, нейросети позволяют выполнять более сложные и изощрённые атаки, адаптирующиеся к конкретным целям и системам защиты.

Особо стоит отметить потенциал обфускации кода с помощью нейросетей. Код, сгенерированный нейросетью, может быть более обфусцированным и сложным для анализа, чем код, написанный человеком. Это затрудняет работу антивирусных программ и специалистов по безопасности, делая обнаружение и нейтрализацию угроз более сложной задачей. Нейросети могут генерировать код, который постоянно меняется, что дополнительно усложняет процесс анализа.

DDoS-атаки с помощью искусственного интеллекта

Хотя DDoS-атаки являются весьма распространённым способом нападения в киберпространстве, использование генеративного ИИ с этой целью можно назвать экзотическим. Но здесь существует брешь.

Генеративный ИИ, так же как и поисковики, использует особые поисковые боты — веб-краулеры. Недавно была обнаружена уязвимость в веб-краулере OpenAI, которая позволяет инициировать DDoS-атаки. Использование API ChatGPT может привести к резкому увеличению трафика на целевой веб-сайт из-за большого количества автоматически сгенерированных запросов.

Хотя мощности поисковых ботов вряд ли будет достаточно, чтобы вывести из строя защищённые ресурсы, краулер ChatGPT, например, способен генерировать от 20 до 5000 запросов в секунду на один запрос к API.

Состязательное машинное обучение (Adversarial Machine Learning)

Adversarial Machine Learning (не путать с Anti Money Laundering) — это область исследований, изучающая атаки на алгоритмы машинного обучения. Существуют атаки особого типа (adversarial-атаки) на алгоритмы машинного обучения, чтобы заставить модель машинного обучения выдать неверный или нежелательный результат. Обычно это достигается путём внесения небольших, часто незаметных для человека, изменений во входные данные. Можно выделить следующие типы атак.

Атаки уклонения (Evasion Attacks)

Злоумышленник изменяет входные данные таким образом, чтобы обмануть модель во время её работы. Например, добавление незначительного «шума» к изображению может привести к тому, что система распознавания лиц не сможет идентифицировать человека. Возможны атаки уклонения в отношении различных типов данных, включая изображения, текст, аудио.

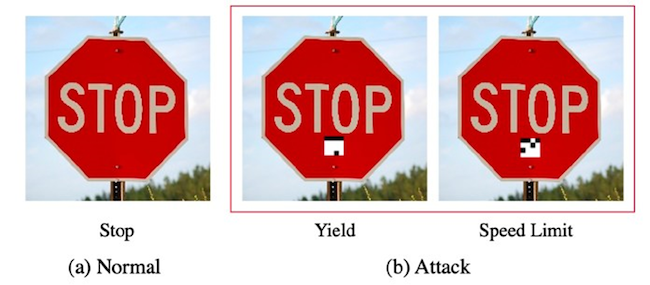

Рисунок 3. Наклейка на стоп-знак

Если речь идёт о изображениях, то, помимо «шума» и незначительных изменений пикселей, можно использовать небольшие наклейки, которые незаметны для человека, но существенно изменяют классификацию объекта. Например, наклейка, нанесенная на стоп-знак, может заставить систему распознавания объектов идентифицировать его как что-то другое. Также эффективны целенаправленные искажения, например изменение освещения или ракурса, специально подобранные для обмана конкретной модели.

Ввод незначительных изменений в текст, например добавление синонимов или незначительное изменение грамматики, может привести к изменению результата анализа текста моделью. Спам-фильтр удаётся обойти путём незначительной перефразировки спам-сообщения. Добавление специально подобранных слов или символов, незаметных для человека, сильно влияет на результаты анализа или классификации текста.

Внедрение высокочастотного шума, не воспринимаемого человеческим ухом, может сделать распознавание речи невозможным. Изменение тембра или скорости речи позволяет обойти системы распознавания голоса. Целенаправленные искажения, например вставка коротких звуков, могут заставить систему распознавания идентифицировать речь как что-то другое.

Атаки уклонения проводятся на этапе эксплуатации системы, когда модель уже обучена и используется для решения практических задач. Их эффективность зависит от уязвимости конкретной модели и сложности метода атаки.

Отравление данных (Data Poisoning)

На этапе обучения модели злоумышленник вводит «отравленные» данные в обучающую выборку. В результате модель начинает выдавать ложные результаты. Рассмотрим примеры:

- Злоумышленник добавляет в обучающий набор множество «хороших» писем, содержащих определённые ключевые слова или фразы, связанные со спамом. Модель может начать ошибочно маркировать эти «хорошие» письма как спам.

- Недобросовестный маркетолог искусственно повышает рейтинг определённого продукта или услуги, добавляя в обучающий набор множество положительных отзывов, сгенерированных автоматически.

- Внесение в обучающую выборку модифицированных изображений известных лиц может привести к тому, что система будет ошибаться в их распознавании или соотносить их с другими личностями.

- Если в обучающий набор для диагностики рака лёгких добавляются изображения здоровых лёгких, помеченные как рак, модель будет давать ложные положительные результаты, ошибочно диагностируя рак у здоровых пациентов.

На эффективность атаки «отравления» данных влияют несколькофакторов: размер обучающей выборки, процент «отравленных» данных и сложность алгоритма машинного обучения. Чем больше процент «отравленных» данных и чем меньше размер обучающей выборки, тем выше вероятность успешной атаки. Сравнительно сложные алгоритмы могут быть более устойчивы к таким атакам.

Извлечение модели (Model Extraction)

Злоумышленник пытается получить доступ к внутренним параметрам модели, чтобы понять её поведение и использовать эти знания для дальнейших атак.

Он посылает запросы к модели и анализирует полученные ответы. На основе полученных данных он пытается построить приблизительную модель поведения целевой системы, даже не имея доступа к её внутренним параметрам. Тут может быть востребован анализ времени отклика модели на различные запросы, чтобы определить сложности вычислений и потенциальные слабые места.

Злоумышленник может попытаться «инвертировать» процесс обучения, начиная с выходных данных и анализируя внутреннюю структуру, чтобы восстановить исходные входные данные.

Защита от рисков, создаваемых ИИ

К счастью, ИИ — это обоюдоострый клинок, и подходов для минимизации рисков достаточно.

Выявление сгенерированного контента

Для начала стоит обзавестись инструментарием для обнаружения сгенерированного контента. На сегодняшний день существует множество способов сделать это.

В качестве примера можно рассмотреть оценку степени редактирования фото и видео, анализ технических метаданных (например, данных акселерометра), а также анализ аудио- и видеозаписей на предмет подозрительных искажений речи и звука с помощью специализированных анализаторов. Проверка метаданных файлов (местоположения, модели камеры) также служит важным инструментом верификации.

Выбивать клин клином весьма эффективно. Выявление артефактов, характерных для дипфейков и других видов подделок, осуществляется с помощью нейронных сетей, анализирующих математические зависимости в изображении на пиксельном уровне. Обучение на большом объёме данных помогает определить типовые паттерны, указывающие на то, что определённый контент сгенерирован.

Ещё один перспективный способ борьбы с дипфейками — маркировка ИИ-контента путём добавления метаданных или видимых водяных знаков к контенту, созданному ИИ. Цель — помочь пользователям и платформам идентифицировать такой контент и оценить его подлинность.

Борьба с использованием ИИ киберпреступниками

В первую очередь важно повышать осведомленность пользователей об угрозах, связанных с использованием нейросетей. Это помогает предотвратить атаки, основанные на социальной инженерии. Специалистам в области защиты от атак, использующих ИИ, предстоит постоянно повышать квалификацию.

Современные антифрод-системы уже используют ИИ для анализа больших объёмов данных и выявления подозрительной активности, этот подход можно использовать и для оценки подозрительного контента.

Обучение моделей на больших объёмах данных, включая примеры фишинговых писем, сайтов и сообщений, позволяет эффективно идентифицировать подозрительную активность. Сюда можно отнести анализ языка, стиля письма, URL-адресов и других признаков.

В плане противодействия созданию вредоносного кода нейросети могут анализировать код на наличие подозрительных фрагментов и функций, которые часто используются во вредоносных программах.

Противодействие adversarial-атакам

Если задача состоит в том, чтобы противодействовать adversarial-атакам, то здесь есть несколько подходов. Самое простое — предварительная обработка данных, чтобы обнаружить и удалить искажения, но это весьма трудоёмкая задача.

Остаётся актуальным повышение устойчивости нейросетей к атакам. Например, в состязательном обучении модель тренируется на специально сгенерированных adversarial-примерах, симулирующих атаки. Это делает модель более точной и устойчивой, позволяя ей игнорировать «шумы» и фокусироваться на важных признаках. Однако защита эффективна только против атак конкретных типов, представленных в обучающей выборке.

Объединение прогнозов нескольких независимо обученных моделей в ансамбль повышает общую надёжность и точность. При adversarial-атаках усреднение прогнозов разных моделей снижает влияние атаки, затрудняя манипулирование. Таким образом, ансамбли защищены более надёжно, чем отдельные модели.

Изменение правового поля

Для снижения рисков генеративного ИИ необходимо комплексное изменение правового поля. Ключевыми направлениями считаются:

- регулирование авторского права и интеллектуальной собственности;

- установление ответственности за контент, сгенерированный ИИ, и механизмов компенсаций для авторов;

- борьба со злоупотреблениями, например фейковыми новостями и дипфейками, путём их законодательного преследования и разработки инструментов их обнаружения;

- обеспечение прозрачности и объяснимости алгоритмов, то есть необходимо решить вышеупомянутую проблему «чёрного ящика».

Регулирование потребует баланса между стимулированием инноваций и защитой прав граждан, особенно в контексте вышеупомянутой проблемы «чёрного ящика». Здесь необходимы гибкие и адаптивные правовые рамки, способные эволюционировать вместе с технологией и эффективно реагировать на новые вызовы, возникающие в связи с развитием генеративного ИИ. Банальный запрет скорее вреден, так как приведёт к неконкурентоспособности: страны, которые не ввели ограничения, будут бенефициарами автоматизации, а те, кто примет запреты будут отставать технологически.

Более того, предстоит сформировать международные нормы регулирования ИИ. На фоне кризиса глобализма и «гонки вооружений» в области ИИ сделать это не так просто. Даже если международное сообщество придёт к консенсусу и ограничит использование генеративного ИИ, скорее всего, подобные исследования всё равно будут продолжаться тайно: этим будут заниматься либо разного рода криминальные группы, либо страны, где формально приняты ограничения, но фактически разработки ведутся.

Выводы

Риски, связанные с использованием генеративного ИИ, многообразны: от угроз конфиденциальности и безопасности данных до возможных нарушений авторских прав и манипуляций общественным мнением. В целом они способны повлиять на многие стороны общественной жизни.

Мы находимся на пороге новой эры, когда последствия «гонки вооружений» в области ИИ будут ощущаться не только в сфере борьбы с мошенничеством и изменениями на рынке труда, но и в контексте глобальной конкуренции государств за технологическое и культурное превосходство. Эта борьба может привести к значительным изменениям в международных отношениях и внутренней политике стран, что подчёркивает необходимость осознания рисков на уровне общества.

Уже существуют эффективные методы, которые могут помочь снизить риски. Многие из них предлагают «вышибать клин клином». Эффективное смягчение рисков возможно благодаря вариативному подход, включающему применение самого ИИ для противодействия его негативным проявлениям (антифрод-системы, детектирование дипфейков, состязательное обучение).

Ключевую роль в обеспечении безопасного использования технологий играют не только технические решения, но и изменение правового поля и повышение осведомленности пользователей. Создание норм и стандартов работы с ИИ поможет предотвратить злоупотребления.

Описание перспектив неправомерного использования ИИ не должно погружать в антиутопию. Целесообразно взвешенно подойти к вопросу о том, как минимизировать риски, связанные с ИИ, и использовать его потенциал для повышения продуктивности труда. Если общество сможет осознанно управлять внедрением и развитием инноваций, генеративный ИИ может стать мощным инструментом для улучшения качества жизни и эффективности работы.