По прогнозам команды экспертов VisionLabs, в 2025 году стоит ожидать многократного роста атак с использованием технологий дипфейка. Под угрозой посягательства находятся как конечные пользователи, так и бизнес и госструктуры. К чему нужно быть готовым уже сейчас и какие меры помогут снизить риски?

- Введение

- Долгий путь и стремительный рывок: как развивались технологии дипфейка?

- Где дипфейки уже применяют для атак?

- Где ещё можно ожидать большего использования дипфейков?

- Меры противодействия

- Выводы

Введение

С 2023 года неуклонно растёт количество атак с использованием технологий, связанных с подменой голоса, изображений и видео на сгенерированные искусственным интеллектом (ИИ). По разным оценкам, и в 2023-м и в 2024 году применение технологий генерации различного контента в злонамеренных целях возросло в несколько раз, от 8 до более чем 30 раз по всему миру.

Согласно прогнозу, который заместитель председателя правления Сбербанка Станислав Кузнецов дал ещё в сентябре 2024 года, увеличение количества атак с использованием дипфейков в России составит 3000 % в годовом выражении. Как показало совместное исследование MTS AI и Б1, к середине января 2025 года от дипфейк-атак пострадала каждая пятая российская компания.

Мошенники задействовали сгенерированный с помощью ИИ контент в различных комбинациях, начиная от модификации схемы BEC (business email compromise) с целью украсть денежные средства у компаний через подставные счета и заканчивая поддельными интимными фото или видео для шантажа.

Однако массовому применению данных технологий препятствовало то, что голос и видео часто были неестественными, а на генерацию видео требовалось время, что мешало использовать его здесь и сейчас. Многие дипфейки 2022 и 2023 годов, кроме наиболее дорогих штучных, можно было выявить буквально невооружённым глазом. У массовых образцов, полученных с помощью бесплатных или наиболее дешёвых инструментов, до сих пор есть видимые недостатки.

Во второй половине 2024 года в распоряжении злоумышленников оказались намного более совершенные нейросети, которые позволяли генерировать чрезвычайно реалистичный контент. Аудиозаписи не только успешно имитировали нужный голос, причём с учётом всех интонаций, но и учитывали особенности речи, включая характерную лексику и дефекты дикции. Средства генерации видео позволяли правдоподобно воспроизводить артикуляцию и, что самое главное, вести диалог в реальном времени.

Всё это дало основания некоторым ИБ-экспертам давать безрадостные прогнозы о том, что в 2025 году стоит ожидать лавинообразного роста атак с использованием дипфейков. По прогнозам VisionLabs (подразделение МТС), численность пострадавших в России может составить 30 млн человек уже в наступившем году.

Не отстают и власти. Так, на форуме «Кибербезопасность в финансах» министр цифрового развития России Максут Шадаев заявил, что обсуждается инициатива считать использование дипфейков отягчающим обстоятельством при совершении преступлений.

Долгий путь и стремительный рывок: как развивались технологии дипфейка?

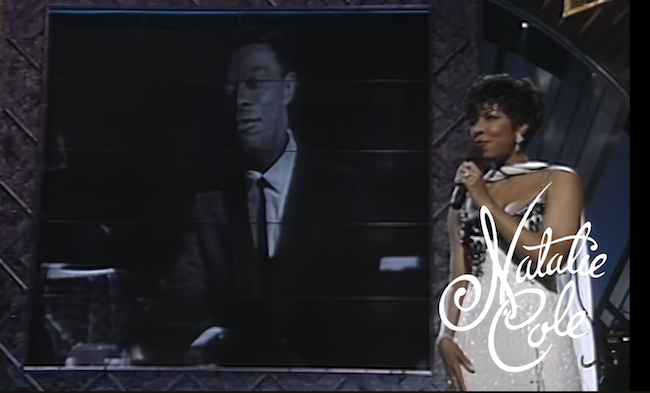

Технология дипфейка появилась довольно давно. Её применяли кинокомпании и клипмейкеры ещё в 1990-е годы. Создание и обработка изображений и звука оказались востребованы на съёмках клипов для альбома Unforgettable, который вышел в 1991 году. Там Натали Коул пела дуэтом с Нэтом Кингом Коулом (рис. 1), хотя последний умер ещё в 1965 году. Кадры с видеоизображениями президентов Джона Кеннеди и Линдона Джонсона включили в фильм «Форрест Гамп», вышедший в 1994 году.

На первых порах технология была дорогой, сложной и трудоёмкой. С технической точки зрения нужны если не суперкомпьютеры, то очень дорогие рабочие станции и часто уникальное ПО. Работать с технологией мог лишь ограниченный круг специалистов. На создание нескольких минут видео могли уходить дни, а то и недели. Цена также зашкаливала. К примеру, клипы к упомянутому альбому Unforgettable стоили на порядок дороже, чем снятые по традиционной технологии. Ролик длительностью 2–3 минуты мог обойтись примерно в миллион долларов, причём в ценах 30-летней давности.

Рисунок 1. Дуэт в клипе Unforgettable

Со временем технологии совершенствовались и становились дешевле и проще. Ситуация принципиально изменилась во второй половине 2010-х годов. Ещё в 2017 году массово появлялись порноролики с подмонтированными лицами других людей. Приложение FakeApp (2018) позволило подменять лица на фото и видео без больших усилий, их изготовление было поставлено на поток.

В 2019 году злоумышленники начали использовать средства синтеза речи в ходе реальных атак. Однако до недавнего времени такого рода случаи были единичными. Нейросетевые инструменты, позволяющие создавать контент с речью, оставались довольно сложными или дорогими, если заказывать их на стороне, а результаты выглядели не слишком реалистично. Подделку выдавала неестественная артикуляция, несоответствие звукового ряда и движений губ. Нередко попадались лишние пальцы на руках или, наоборот, пальцев не хватало.

На рубеже 2023 и 2024 годов произошёл технологический прорыв: появились инструменты (см. таблицу), позволяющие весьма убедительно имитировать голос любого человека, причём для «обучения» достаточно образцов речи общей длительностью не больше минуты. Можно обойтись коротким телефонным разговором.

Во второй половине 2024 года разработка средств генерации высокореалистичного видео вышла на новый уровень. Последние версии лишены указанных выше недостатков. Все желающие, в том числе злоумышленники, получили в своё распоряжение средства, позволяющие создавать видео в режиме реального времени. Пока качество картинки довольно низкое, но его достаточно для использования в сеансах видео-конференц-связи.

Радикально снизилась себестоимость создания дипфейков. По данным «Лаборатории Касперского», в мае 2023 года создание ролика обходилось минимум в 200 долларов за минуту. Однако уже через месяц появились сервисы «дипфейк как услуга», где цена дошла до 145 долларов за минуту. В 2024 году намного более качественный материал можно было сгенерировать бесплатно.

Таблица 1. Инструменты, используемые для генерации дипфейков

|

Тип дип фейка |

Исходные данные |

Технология и инструмент |

|

Фото и видео |

Снимки; видеозаписи с конкретным человеком, на которых нейросетевые модели проходят обучение (английский, русский и другие языки) |

Faceswap, DeepFaceLab, DeepFaceLive, FSGAN, FaceShifter, SimSwap, FaceForensics++. Мобильные приложения Reface, FaceApp или Avatarify |

|

Аудио |

Голос конкретного субъекта. Есть решения one-shot, которым нужно буквально несколько секунд аудиозаписи |

Фреймворки и библиотеки, в которых реализованы перевод текста в речь (TTS) и преобразование голоса (VC). ElevenLabs, PlayHT, Amazon Polly, FakeYou, CloudTTS, Speechify |

|

Текст |

Материалы Reddit, Wikipedia и других источников |

ChatGPT (GPT-4), LlaMA 2, Claude 2 и другие |

Где дипфейки уже применяют для атак?

Сегодня мошенники успешно используют технологии дипфейка для атак различных типов. Кроме того, сгенерированный ИИ контент применяется в различных программах манипуляции общественным мнением, в том числе в ходе электоральных процессов.

По данным исследования, проведённого интегратором «Информзащита» осенью 2024 года, в атаках с использованием технологий дипфейка вероятность того, что злоумышленники добьются своего, составляет около 20 %. Это приблизительно вдвое выше, чем у обычных телефонных мошенников.

Рассмотрим наиболее характерные примеры в хронологическом порядке.

Схемы с шантажом

В 2017 году появились доступные для неспециалистов в области видеомонтажа инструменты, позволяющие подменять лица на фото и видео. Чуть позже началось массовое использование данной технологии для шантажа. Обычно объектом таких манипуляций становились школьницы или студентки. В качестве исходного материала злоумышленники берут фотографии и видеоролики из социальных сетей. В основном такая практика получила развитие в Южной Корее и Японии, но немало случаев отмечается и в других странах.

В России случаи шантажа с подменой изображений фиксируются с 2020 года. Как отметил в комментарии для «Известий» член Московской коллегии адвокатов «Бородин и партнёры» Владислав Шурховецкий, такую схему используют:

- те, кто хочет отомстить бывшим партнёрам;

- мошенники и вымогатели, которые пытаются шантажировать потенциальных жертв публикацией интимных снимков или разговоров.

Жертвами становятся публичные или просто состоятельные люди. Иногда таким образом пытаются манипулировать участниками судебных процессов или сослуживцами. Часто распространение таких роликов является частью кибертравли.

Манипуляция общественным мнением

Попытки использовать дипфейки в политических целях начались ещё во второй половине 2010-х годов. Тогда сгенерировали ролик, где бывший президент США Барак Обама ругал пришедшего ему на смену Дональда Трампа.

«Наличие дезинформации в избирательных процессах может серьёзно дестабилизировать реальную и кажущуюся легитимность избранных правительств, что может привести к политическим беспорядкам, насилию и терроризму, а также к подрыву демократических процессов в долгосрочной перспективе», — говорилось в докладе, подготовленном ко Всемирному экономическому форуму в январе 2024 года.

Первые попытки были предприняты в Словакии и Молдавии в 2023 году. Массовое использование дипфейков в политике развернулось в 2024-м. Такого рода материалы оказались востребованы в ходе кампаний в Индии, США, несколько меньше — накануне выборов в Европейский парламент.

В политической борьбе на парламентских выборах в Индии весной 2024 года дипфейки использовала как правящая партия, так и оппозиция. Многие жители страны, особенно пожилые, технически неграмотны и не способны отличить подлинный видеоролик от сгенерированного. Недобросовестные политики воспользовались ситуацией. Их ролики эксплуатировали сложные межконфессиональные и межкастовые отношения в индийском обществе.

В России также обратили внимание на проблему использования дипфейков в политической агитации. Пленум Верховного суда РФ принял постановление от 25.06.2024 № 17 «Об отдельных вопросах, возникающих у судов при рассмотрении дел об административных правонарушениях, посягающих на установленный порядок информационного обеспечения выборов и референдумов». Нормативный правовой акт запрещает использовать дипфейки для создания любых агитационных материалов в ходе выборов и референдумов. Нарушителя ждёт административный штраф до 30 тыс. рублей для физических и до 500 тыс. рублей для должностных лиц.

Атаки от имени руководства

Наибольшее распространение получили атаки, где злоумышленники обращаются к жертве от имени её руководителя. Считается, что впервые серьёзный ущерб был нанесён в 2019 году, когда мошенники украли около 240 тыс. долларов в британском филиале немецкой компании.

Сотрудник отправил средства на оплату счёта. Сделать это ему велел якобы лично генеральный директор головного предприятия. Злоумышленникам удалось довольно точно воспроизвести особенности речи, в том числе характерный акцент. Однако то, как это было сделано, вызывает вопрос, применялись тут технологии синтеза речи с помощью ИИ или просто кто-то умело подражал голосу топ-менеджера.

Благодаря дипфейку повышаются шансы на успех стандартной аферы BEC (business email compromise, компрометация служебной электронной почты). Обычно звонки совершаются от имени директоров и топ-менеджеров компании, требующих оплатить счёт. Жертвами оказываются сотрудники финансовых подразделений, менеджеры по работе с клиентами, секретари и помощники руководителей. Атака по такому сценарию распространена и в мире и в России. По данным уже упоминавшегося исследования МТС и Б1, с подобной атакой сталкивалась каждая пятая российская компания.

В мировом масштабе максимальная сумма ущерба составила 35 млн долларов. Именно столько было украдено в 2024 году при атаке на один из банков в ОАЭ. Мошенники создали имитацию голоса топ-менеджера кредитной организации. В гонконгском филиале одной из международных компаний было украдено 26,5 млн долларов.

Российской спецификой являются звонки от имени руководства с оповещением о том, что скоро на связь выйдут представители правоохранительных или контролирующих органов. Таким образом, злоумышленники используют дипфейки, чтобы придать убедительности традиционным сценариям телефонного мошенничества. Практика стала массовой уже в начале 2024 года.

Телефонное мошенничество «Мама, я попал в беду»

По мнению экспертов, наиболее распространён сценарий злонамеренного применения дипфейков, где мошенник выступает от лица родственника. О таком сценарии предупреждал, в частности, Банк России. Потенциальная жертва слышит знакомый голос и менее критично воспринимает информацию.

Схема широко распространилась по всему миру с начала 2010-х годов. Пока мошенники не слишком активно применяют данную технологию в России. Однако, судя по косвенным данным, например большему интересу мошенников к образцам голосов россиян, вполне вероятно, что данная практика станет массовой. Мошенники даже готовы покупать образцы голосов, причём за довольно значительные суммы (до 5000 рублей).

Атаки на пользователей мессенджеров

С помощью стандартных техник злоумышленники получают доступ к учётным записям пользователя мессенджера, а затем от имени конкретного человека начинают просить его знакомых о материальной помощи. Часто обращения подкрепляются сообщением, сделанным на основе голоса жертвы. В качестве образцов для обучения используются фрагменты, найденные во взломанной учётной записи. Считается, что схема получила широкое распространение с ноября 2023 года.

Недобросовестная реклама

Чаще всего дипфейки используют для рекламы ресурсов, занимающихся криптоскамом — мошенничеством с криптовалютами. Для привлечения внимания к таким сайтам или каналам используются видео с участием различных медиаперсон, политиков, бизнесменов, спортсменов (рис. 2). Ролики, которые генерируют с помощью наиболее ходовых инструментов, как платных, так и бесплатных, имеют заметные дефекты, очевидна неестественная мимика.

Видео ориентированы на англоязычную аудиторию и размещаются на международных площадках, прежде всего в социальных сетях и на видеохостингах. На глобальном рынке охват выше, как и потенциальные заработки. Есть и группировки, специализирующиеся на русскоязычной аудитории, в конце 2024 года их было как минимум пять, по данным компании F6.

Также мошенники применяют дипфейк-ролики для того, чтобы заманить потенциальных жертв на фишинговые сайты. Обычно в ход идут видео порнографического характера, но не только.

Рисунок 2. Бот в Telegram, генерирующий дипфейк-ролики для рекламы криптоскама

Где ещё можно ожидать большего использования дипфейков?

Мы подобрали схемы, которые появились относительно недавно, но считаются перспективными и потенциально опасными для людей и компаний.

Мошенничество с фиктивными знакомствами

Мошенники стали заметно активнее выманивать у пользователей сервисов знакомств деньги. Для этого они придумывают вымышленную личность, которой никогда не было. Так, злоумышленники модернизировали уже давно существующую схему, позволяющую разными способами выманивать деньги у потенциальных жертв. В компании VisionLabs уже выявили не менее десяти случаев использования подставного персонажа для фальшивых свиданий, причём в каждом инциденте ущерб составил не меньше миллиона рублей.

Наиболее активны на данном поприще «нигерийские» злоумышленники, преимущественно подростки. Мошенники используют разные предлоги для выманивания денег. Тут востребованы техники, аналогичные тем, что отработаны в ходе аферы «нигерийские письма», существующей более 30 лет. Поводы для выманивания денег могут быть разными, от покупки билетов на транспорт до сбора средств на лечение.

Как предупреждают эксперты, злоумышленники также занимаются фишингом, аферами с криптовалютами или угрозами опубликовать фото или видео интимного характера. Для привлечения потенциальной аудитории часто идёт в ход порнографический контент, опять же сгенерированный ИИ.

По оценке VisionLabs, в ближайшем будущем количество потенциальных жертв атак в России может достичь 30 млн человек. Прогноз вполне оправдается, если мошенники освоят применение ИИ, чтобы подыскивать потенциальных жертв и подбирать техники воздействия на них.

Кроме сервисов знакомств, мошенники задействуют социальные сети, особенно мессенджеры с их многомиллионной аудиторией. По данным VisionLabs, именно атаки через мессенджеры наиболее эффективны. Для сравнения: результативность действий через соцсети довольно низкая.

Противостоять подобным преступлениям проблематично, поскольку пострадавшие редко обращаются к администрации сервисов и в правоохранительные органы. Особенно часто такая ситуация складывается в случае шантажа интимными фото или видео.

Мошенничество с трудоустройством

Подлог в сфере трудоустройства — довольно перспективная форма мошенничества. Вполне очевиден её потенциал для атак, связанных с кибершпионажем, как государственным, так и корпоративным. Проникновение в компанию позволяет получить значимые данные, которые могут оказаться полезными для преступников.

Пока таких случаев не так много, а об успешных примерах вообще малоизвестно. Первые попытки отмечены ещё в 2022 году, когда действовали ковидные ограничения и многие компании привлекали удалённых сотрудников. Как правило, злоумышленников подводили небрежность и низкое качество контента.

Преступника, который пытался устроиться на работу в стартап Vidoc Security Lab, выдала речь с азиатским акцентом, что не соответствовало легенде соискателя. Помешали и характерные дефекты на видео, которое мошенник использовал во время контактов с компанией.

Уже сейчас в распоряжении всех желающих есть инструменты, позволяющие избежать ошибок, допущенных в ходе провалившихся атак. Вполне вероятно, что в самом ближайшем будущем стоит ожидать новой волны такого рода нападений и они могут оказаться успешными.

Подделка средств биометрической идентификации

По оценкам Gartner, к 2026 году технологии достигнут такого уровня развития, что нынешние системы биометрической идентификации будут полностью скомпрометированы. Однако системы защиты биометрических данных не останутся прежними. По мнению аналитиков, «соотношение сил» вряд ли кардинально изменится.

Довольно давно существуют троянские программы, которые с помощью методов социальной инженерии пытаются заставить жертву сканировать лицо и документы, удостоверяющие личность. Предположительно, такие решения созданы преступными группировками с целью собирать данные для генерации дипфейков.

Как показал опрос, проведённый журналом «Плас», в России преобладают довольно пессимистические оценки того, насколько биометрические системы способны выявлять попытки их обмана с помощью дипфейков (рис. 3). Возможно, они продиктованы общим настороженным отношением к биометрии со стороны россиян.

Рисунок 3. Результаты опроса о влиянии дипфейков на внедрение биометрической идентификации

Меры противодействия

Для противодействия атакам с использованием дипфейков нужен комплексный подход. Востребованы не только технические средства, но и организационные меры, а также программы повышения осведомлённости пользователей, как корпоративных, так и обычных.

Технические средства выявляют характерные артефакты, которые появляются в сгенерированных ИИ аудиозаписях и на изображениях, как статичных, так и видео. Соответствующие инструменты доступны на рынке с того момента, как стали доступны приложения, позволяющие подменять лица на фото и видео. Среди таких средств есть и российские разработки.

По оценкам экспертов, профильные приложения довольно уверенно выявляют низкосортные дипфейки, применяемые в ходе массовых атак. Однако высококачественные подделки, которые востребованы при попытках украсть действительно крупную сумму, они могут и пропустить.

Не исключены и ложноположительные срабатывания. Например, один из популярных сервисов по выявлению дипфейков признал видео с новогодним поздравлением президента Казахстана сгенерированным нейросетью.

Что касается средств правового регулирования, то разработать его не так просто. Тем более что у технологии дипфейков есть и легитимное применение, например в кино или рекламе. Примером тому является включение кадров с Юрием Никулиным в вышедший в 2024 году фильм «Манюня».

Подходы, которые в теории кажутся работоспособными, на практике оказываются малоэффективными. В качестве примера приведём C2PA — своего рода цифровые отпечатки, позволяющие идентифицировать контент, сгенерированный ИИ.

Многие нейросетевые инструменты имеют открытый код, откуда при желании можно изъять любые механизмы, ограничивающие применение для тех или иных целей, в том числе противоправных. В случае дипфейков речь идёт, прежде всего, о фото и видео интимного характера.

Как показал опыт, наиболее эффективным механизмом противодействия любым угрозам является повышение осведомлённости. Если речь заходит о материальной помощи или оплате каких-то счетов, любое подобное обращение нужно тщательно проверить.

Выводы

К сожалению, высока вероятность того, что сбудутся безрадостные прогнозы, которые сделали аналитики на текущий год. Действительно, технологии совершили очередной фазовый переход и позволяют генерировать контент, обладающий высокой реалистичностью. И киберпреступники не замедлили взять их на вооружение. Косвенным свидетельством этого считается значительный рост спроса на образцы голоса со стороны криминальных кругов.

Технические средства защиты от дипфейков уже доступны, но их эффективность недостаточна для уверенной диагностики. Результативность снижается по мере того, как совершенствуется инструментарий злоумышленников.

Использование средств маркировки контента, сгенерированного с помощью ИИ, и внесение изменений в массовые нейросетевые инструменты вряд ли решат проблему. Злоумышленники не будут использовать распространённый инструментарий или найдут методы, как обойти встроенные программы противодействия.

Остаётся повышать осведомлённость широких масс пользователей, прежде всего наиболее уязвимых категорий: детей и подростков, женщин и пожилых людей. Такую миссию могут взять на себя предприниматели, государство, общественные организации и СМИ.