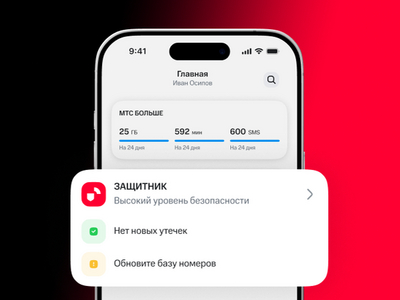

МТС объявил о запуске новой услуги: абоненты смогут в реальном времени получать уведомления (СМС, пуши) о подозрительных звонках членам их семьи. Новая функция доступна в рамках платной подписки «Защитник+ для семьи».

В пакет также включены сервис блокировки мошеннических и спам-звонков, услуга «Безопасный звонок» и страхование (в случае кражи денег посредством телефонного мошенничества МТС поможет вернуть до 1,5 млн рублей).

Комплексную защиту можно распространить на своих близких (до трех дополнительных участников), создав семейную группу. Отдельной платы за это взиматься не будет.

«Злоумышленники продолжают звонить менее информированным и защищенным людям, — поясняет Андрей Бийчук, директор Центра продуктов телеком-технологий. — Например, пожилые могут не распознать в моменте новую схему обмана, а дети и подростки, как правило, не обладают достаточным опытом и критическим мышлением».

По данным МТС, в 2025 году ее ИИ-охранник «Безопасный звонок» отрабатывал у детей и людей преклонного возраста в два раза чаще, чем у других абонентов. При этом пенсионерам мошенники предпочитали звонить около 11-ти утра, а подросткам — в районе 14:00, когда те обычно приходят домой из школы.

Остается надеяться, что с вводом в строй новой единой антифрод-платформы борьба с телефонным мошенничеством в России вступит в новую фазу и принесет долгожданные, еще более существенные плоды.